千亿级!墨芯公布最新大模型适配成果 @世界人工智能大会

2023-07-06

2023-07-06

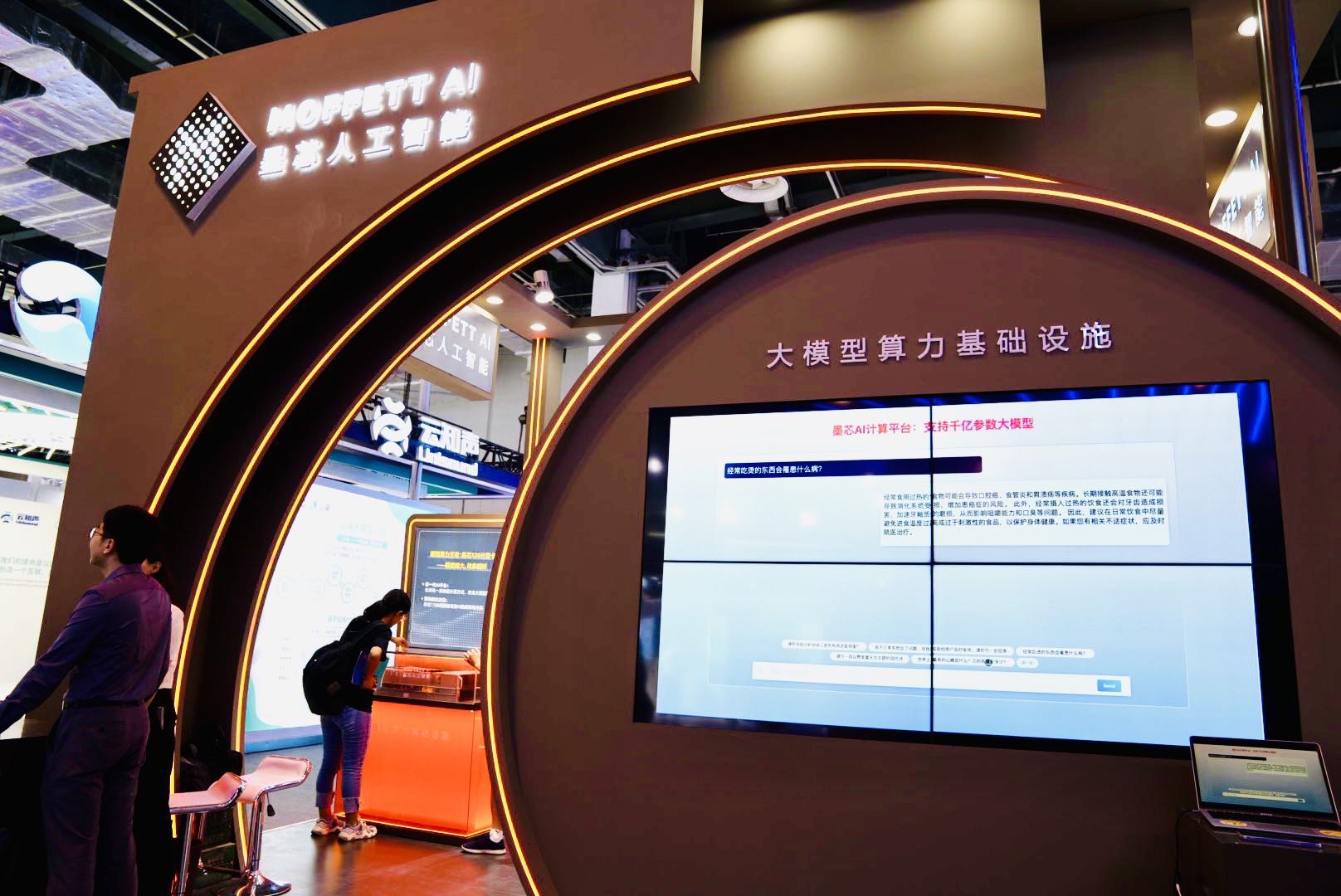

7月6日,在世界人工智能大会WAIC上,墨芯人工智能发布了大模型算力方案的最新成果,宣告进入“千亿“阶段:墨芯AI计算平台率先支持高达千亿参数的大语言模型,并在吞吐、延时等多项指标上表现优异,创下又一里程碑。

在活动现场,墨芯展台成为全场热点:1760亿参数的大语言模型Bloom在墨芯AI计算平台的推理引擎支持下,能够快速、流畅地回答各类问题,并完成诗歌创作、文案撰写等多项语言生成任务,赢得现场观众的关注与赞叹。

墨芯在千亿参数大模型上的卓越表现,不仅再次彰显出众的产品技术优势,更是意义重大的行业性突破:

当前,算力瓶颈已成为大模型落地应用的普遍痛点。墨芯针对大模型打造更高性能、更优化的方案,缓解算力之困,为AIGC等大模型应用释放出巨大的应用空间,真正带来“好用”、“用得起”的大模型算力方案。

这对AIGC产业发展具有重要意义——

表明墨芯能够为行业带来新的空间:将有力助推AIGC等大模型进入多行业应用,为企业、科研机构提供高效的算力支持,加速最新大模型成果走向社会、走向更多行业;同时帮助AI企业建立先发优势,加入AIGC潮流。

一起来了解,墨芯的“千亿时刻“,所包含的重要突破——

行业先发,首屈一指

支持千亿大模型

AIGC背后,是动辄百亿、千亿参数的AI大模型,对算力基础设施带来巨大挑战。

墨芯支持高达千亿参数模型,率先突破行业瓶颈,成为业内为数不多的、能够支持大模型落地的AI芯片企业。

性能优异,加速AIGC

吞吐高达432 token/s

在ChatGPT等在线式AIGC应用中,AI内容生成速度是最关键的指标之一,墨芯的AI计算平台展示出高吞吐、低延时的优势:

在1300亿参数ChatGLM大模型上,8张墨芯S30计算卡吞吐达432 token/s,性能超过主流GPU,大幅加快响应速度,极大地优化了用户体验。

助力AI降本增效

仅用8卡

由于大模型的参数大、内存占用大等问题,一般需要数张、乃至数十张AI计算卡,才能支持百亿、千亿参数大模型推理。

在活动现场,墨芯仅采用8张S30计算卡,就展现出高吞吐、低延时等优异性能,同时功耗远低于旗舰GPU。这意味着能够为AI企业减缓算力基础设施与运营成本压力,达到降本增效的目标。

应用范围广

支持主流大模型

墨芯AI计算平台可支持不同参数级别的大模型,包括 BLOOM、OPT、GPT-X、LLAMA、StableDiffusion等主流大模型,能够为大模型在各行业、各类场景中的应用带来加速。

在WAIC现场,墨芯还展示了MLPerf冠军产品——墨芯AI卡计算卡、AI集成架构方案等众多展品,吸引了众多嘉宾、观众与媒体的好评。

墨芯在千亿参数大模型上的突破,再次显示出稀疏计算的巨大优势,有效解决算力资源不足、功耗等运营成本巨大等行业痛点。墨芯率先将稀疏化算法与硬件结合落地,深度挖掘与释放了稀疏计算在大模型上的潜力与价值,为行业带来大模型算力的“最佳实践“。

这不仅为AI算力的未来发展带来了可行的创新路径,为将来更大模型、更复杂应用的发展奠定基础,更为AIGC等大模型应用的广泛落地打开了空间,为新一轮智能革命提供加速引擎,让AIGC的发展迎来新天地。

在活动现场,墨芯展台成为全场热点:1760亿参数的大语言模型Bloom在墨芯AI计算平台的推理引擎支持下,能够快速、流畅地回答各类问题,并完成诗歌创作、文案撰写等多项语言生成任务,赢得现场观众的关注与赞叹。

墨芯在千亿参数大模型上的卓越表现,不仅再次彰显出众的产品技术优势,更是意义重大的行业性突破:

当前,算力瓶颈已成为大模型落地应用的普遍痛点。墨芯针对大模型打造更高性能、更优化的方案,缓解算力之困,为AIGC等大模型应用释放出巨大的应用空间,真正带来“好用”、“用得起”的大模型算力方案。

这对AIGC产业发展具有重要意义——

表明墨芯能够为行业带来新的空间:将有力助推AIGC等大模型进入多行业应用,为企业、科研机构提供高效的算力支持,加速最新大模型成果走向社会、走向更多行业;同时帮助AI企业建立先发优势,加入AIGC潮流。

一起来了解,墨芯的“千亿时刻“,所包含的重要突破——

行业先发,首屈一指

支持千亿大模型

AIGC背后,是动辄百亿、千亿参数的AI大模型,对算力基础设施带来巨大挑战。

墨芯支持高达千亿参数模型,率先突破行业瓶颈,成为业内为数不多的、能够支持大模型落地的AI芯片企业。

性能优异,加速AIGC

吞吐高达432 token/s

在ChatGPT等在线式AIGC应用中,AI内容生成速度是最关键的指标之一,墨芯的AI计算平台展示出高吞吐、低延时的优势:

在1300亿参数ChatGLM大模型上,8张墨芯S30计算卡吞吐达432 token/s,性能超过主流GPU,大幅加快响应速度,极大地优化了用户体验。

助力AI降本增效

仅用8卡

由于大模型的参数大、内存占用大等问题,一般需要数张、乃至数十张AI计算卡,才能支持百亿、千亿参数大模型推理。

在活动现场,墨芯仅采用8张S30计算卡,就展现出高吞吐、低延时等优异性能,同时功耗远低于旗舰GPU。这意味着能够为AI企业减缓算力基础设施与运营成本压力,达到降本增效的目标。

应用范围广

支持主流大模型

墨芯AI计算平台可支持不同参数级别的大模型,包括 BLOOM、OPT、GPT-X、LLAMA、StableDiffusion等主流大模型,能够为大模型在各行业、各类场景中的应用带来加速。

在WAIC现场,墨芯还展示了MLPerf冠军产品——墨芯AI卡计算卡、AI集成架构方案等众多展品,吸引了众多嘉宾、观众与媒体的好评。

墨芯在千亿参数大模型上的突破,再次显示出稀疏计算的巨大优势,有效解决算力资源不足、功耗等运营成本巨大等行业痛点。墨芯率先将稀疏化算法与硬件结合落地,深度挖掘与释放了稀疏计算在大模型上的潜力与价值,为行业带来大模型算力的“最佳实践“。

这不仅为AI算力的未来发展带来了可行的创新路径,为将来更大模型、更复杂应用的发展奠定基础,更为AIGC等大模型应用的广泛落地打开了空间,为新一轮智能革命提供加速引擎,让AIGC的发展迎来新天地。

粤ICP备2021128059号

粤ICP备2021128059号